The Sound and the Social

– Sonification in Social Research

1. The Sound and the Social – Social changes in Germany

1. Population forecast by the Federal Statistical Office for the Federal Republic of Germany from 2014 to 2060 Sonification describes the conversion of data into sounds. This data information is linked to various sounds using software, for example.

2. Risk of poverty in different age groups according to men, women and overall

3. The social situation of women in the west and in the east

4. Change in social values in Germany, shown on the basis of the decrease in values for the importance of law and order from 1991 to 2017 for West and East Germany.

Data visualisation of social changes sonification

Sound of the social:#sonification and #data visualisation #dataviz in #socialsciences

Social changes in Germany

1. Population forecast

2. Risk of poverty

3. Social situation of women

4. Change social values #sounddesign #soundart #VisualArt https://t.co/IVv7mktgR6 pic.twitter.com/B0iFxlu9TU— Joachim Allhoff (@allhoff_joachim) September 12, 2021

https://platform.twitter.com/widgets.js

2. Sound of the social – Social milieus

Within social research, data are usually presented in diagrams or tables. However, there are already various approaches that deal with sonification. For this sonification project, data from the five different German social milieus by german social scientist Gerhard Schulze were processed and converted using the Sonification Sandbox software.

Schulze distances himself from stratification and class theories . In his milieu model several experience patterns dominate in different milieus. Based on these milieus, Schulze defines the term experience society as „… a society that is relatively strongly shaped by internally oriented life views.“

In his model five milieus are described, which are characterized and named more strongly through leisure activities and chosen lifestyle (in hierarchical grading):

• High-class milieu (academics)

• Self-realization milieu (students)

• Integration milieu (employees and civil servants)

• harmony milieu (old workers)

• entertainment milieu (young workers)

Data visualisation of social milieu sonification

Sound of the social:#sonification and #data visualisation #dataviz in #socialsciences

Social milieus according to German social scientist Gerhard Schulze#sounddesign #soundart #VisualArt https://t.co/IVv7mktgR6 pic.twitter.com/XsydoHfqRI

— Joachim Allhoff (@allhoff_joachim) September 11, 2021

https://platform.twitter.com/widgets.js

See also Data Sonification Archive: https://sonification.design/

Hear the Interview with German Radio SWR2 about Sonification in Social Sciences:

https://dokublog.de/mp3/joachim-allhoff-sonifikation

Paper for the Conference

ICAD 2022, the 27th International Conference on Auditory Display, will be held virtually, June 24–27, 2022.

#TwitterResearchProject: #SocialNetworkAnalysis #SNA

Video of #Gephi Analysis#OpenData #DataScience #MachineLearning #OpenScience #Rstats #vosonSML #nodexl #gephihttps://t.co/dfOki7Plag pic.twitter.com/olR46J7hIZ

— Joachim Allhoff (@allhoff_joachim) April 5, 2021

https://platform.twitter.com/widgets.js

Text Mining in der Praxis

In Unternehmen können sehr große Mengen an diesen Textinformationen anfallen sein. Dies können zum Beispiel Produkt- oder Service-Bewertungen, Einträge auf Webseiten, Foren, Social Media Beiträge, Bewertungsportale oder Textdaten aus Umfragen sowie E-Mails mit Kunden-Feedback aus dem Kundenservice sein. Die großen Textmengen und die Extraktion von relevanten Daten aus Dokumenten mit unstrukturierter Formatierung sind dabei für Unternehmen häufig eine große Herausforderung. Mit Hilfe von Text Mining lassen sich diese Datenmengen schnell auswerten und für Unternehmen einen Mehrwert bedeuten.

Diese Informationen können für die Markt-, Wettbewerberanalyse, für Customer Services, Social Media Analysis, Marken-Monitoring oder auch Online-Marketing und Werbung, Suchmaschinen-Optimierung, Verbesserung des Kundenservices oder die frühzeitige Erkennung und Verhinderung von Shit-Storms in der Kundeninformation genutzt werden.

Diese großen Mengen an Textdaten lassen sich kostensparend nur automatisiert auswerten. Hier kommt das Text Mining ins Spiel, also die automatisierte Verarbeitung von Textdaten. Damit können aus großen Datenmengen wesentliche Informationen extrahiert und für Unternehmen nutzbar machen.

Das Text Mining greift auf Ansätze der Linguistik und der Statistik zurück, um aus den Textdaten Kernformationen zu extrahieren. Durch die Analyse von Texten mittels einer Text-Analysesoftware können sich Menschen die arbeitsintensive Aufgabe ersparen, Texte Wort für Wort zu lesen.

Ablauf eines Text Mining-Prozesses

Im Folgenden werden wesentliche Arbeitsschritte innerhalb des Text Mining Prozesses vorgestellt:

Zuerst erfolgt das Information Retrieval, also die Sammlung, Auswahl und Speicherung der verschiedensten Datenquellen wie E-Mail-Texte aus dem Kundenservice, Beiträge aus Social Media oder anderen Quellen, die für die weitere Analyse herangezogen werden sollen.

Der nächste Schritt ist dann Vorverarbeitung der Textdaten. Dazu gehören

- das Einlesen der Texte

- die Textaufbereitung bzw. Formatierung der Textdaten

- die Bereinigung der Textdaten (Punkte, Kommas, Leerstellen usw.)

- das Entfernen von sog. Stopwörtern (also Wörter, die inhaltlich keinen wesentlichen Mehrwert ergeben)

- die sogenannte Tokenisierung. Die Tokenisierungumfasst die Segmentierung von Buchstabenketten in einzelne Absätze, Wörter und Sätze (s. Token).

- das sogenannte Stemming: Hierbei werden die Präfixe und Suffixe von Wörtern getrennt, um den Wortstamm und die entsprechende Bedeutung abzuleiten

- Danach erfolgt die Erstellung einer Dokumentenmatrix mit den verwendeten Texten.

Erst dann beginnt die inhaltliche Analyse und Datenvisualisierung, beziehungsweise die Extraktion von Informationen, das Herausfinden von Mustern in den Textdaten und die Gewinnung neuer Erkenntnissen. Darauf aufbauend können dann die Ergebnisse genutzt werden und Handlungsableitungen ermittelt werden. Typische Analyse-Beispiele sind im Folgenden dargestellt:

Themen-Analyse: Die einfachste Form der Darstellung sind Wörter und die jeweilige Häufigkeit der Nennungen.

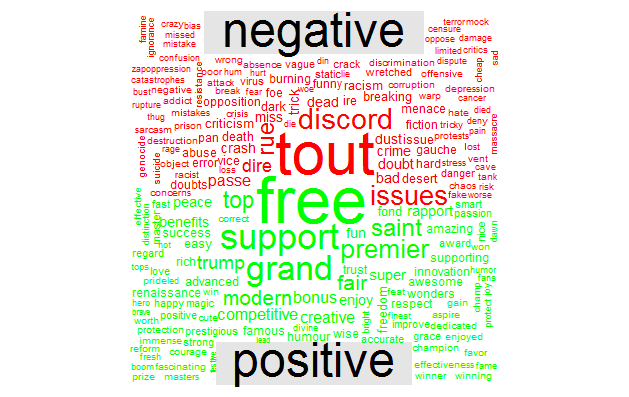

Word Cloud: Word Clouds zeigen ebenfalls einzelne Wörter. Je häufiger diese genannt werden, desto größer erscheinen sie in der Darstellung als „Wörter-Wolke“.

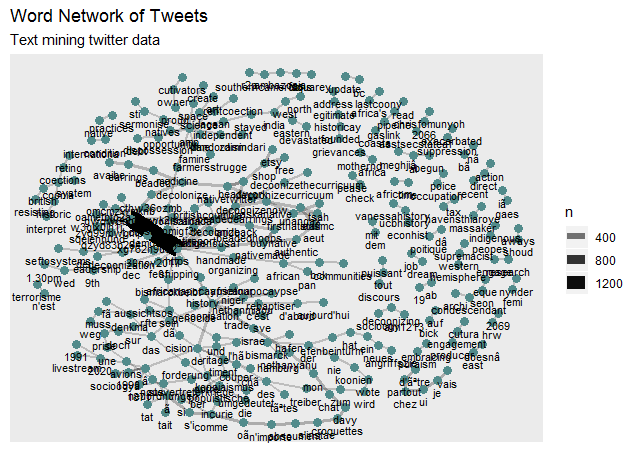

Wort-Netzwerke: Über die Wort-Häufigkeiten hinaus können die Wörter, die häufig gemeinsam genannt werden, zu einen Wort-Netzwerk erweitert werden.

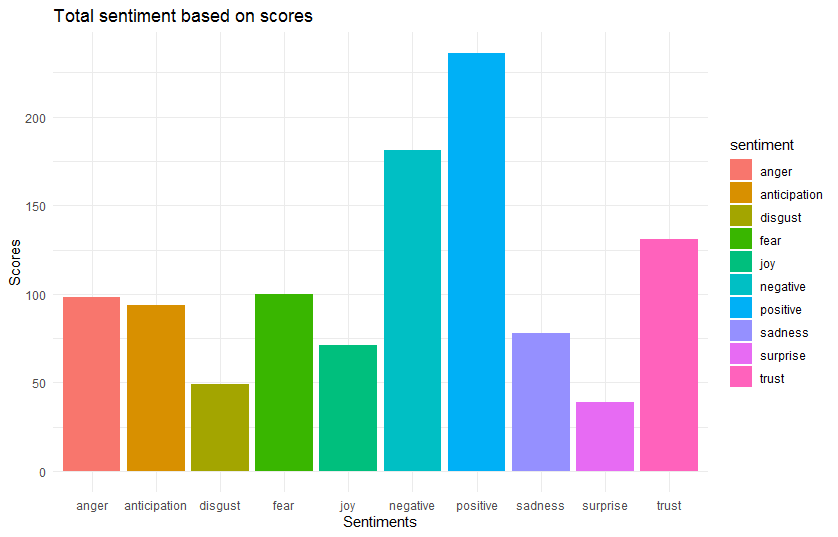

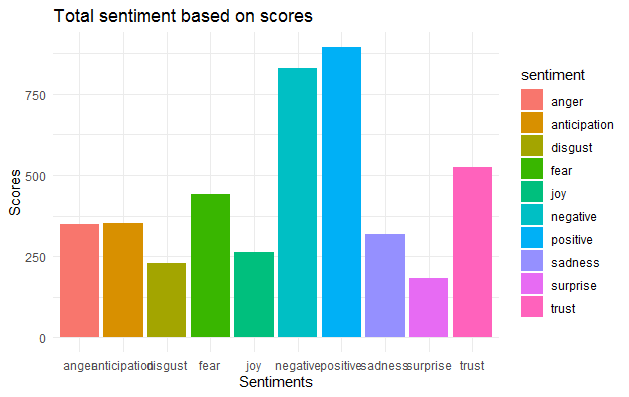

Sentiment-Analyse: Die Sentiment-Analyse klassifiziert die Bedeutung von Wörtern als positiv, negativ oder neutral. Auch diese Wörter können dann mit ihrer entsprechenden Häufigkeit angegeben werden.

Emotions-Analyse: Eine weitere Möglichkeit über Sentiments hinaus ist dann Ableitung von verschiedenen Emotionen auf der Basis der benutzen Wörter wie Ärger, Freude, Angst, Vertrauen oder Überraschung.

Software für Text Mining

Es gibt eine Vielzahl an Software für Text Mining. Im Folgenden sind einige besonders bekannte kommerzielle und Open-Source-Anwendungen aufgeführt:

IBM SPSS Modeler: Diese Anwendung für Data Science benötigt keine Programmier-Kenntnisse und ist mit Drag-and-Drop-Benutzeroberfläche ausgestattet.

Knime: Auch diese Open-Source-Plattform bietet eine Drag-and-Drop-Benutzeroberfläche und ist neben Text-Mining auch allgemein im Bereich Data Science nutzbar.

Rapid Miner Text Processing Extension: Bis vor einigen Jahren noch in einer etwas abgespeckten Form als Open-Source verfügbar, ist diese Anwendung mit einer Text Mining Erweiterung für alle Data-Science-Anwendungen nutzbar und über eine Drag-and-Drop-Benutzeroberfläche zugänglich.

SAS Text Miner Diese Software ist ebenfalls über eine Drag-and-Drop-Benutzeroberfläche nutzbar.

Orange text mining add-on: Orange reiht sich in die Liste der Open-Source-Anwendungen mit einer Drag- and Drop-Oberfläche ein. Für Text Mining steht ein add-on zur Verfügung.

R Package tm: Die Open-Source-Programmiersprache R hat sich mit verschiedenen Packages (z.B. das tm package) zu einem Standard in Data Science und auch im Text-Mining entwickelt.

Python

Auch diese Open-Source-Anwendung ist ein Standard für Datenanalysen und Text Mining und darüber hinaus auch für (Software-)Programmierungen geeignet.

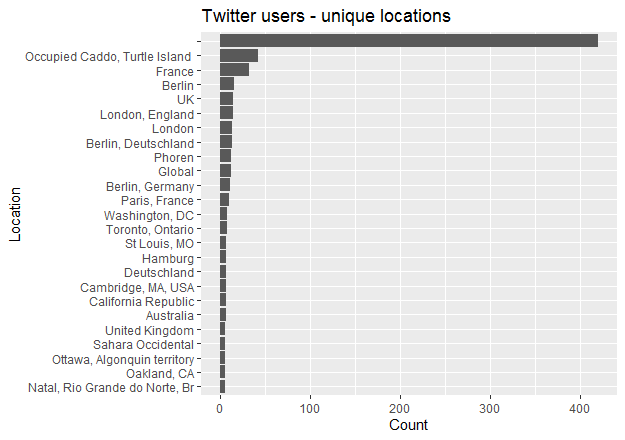

#TwitterResearchProject

- Searching and analyzing tweets about special cultural or political topics (i.e. hashtags about #Colonisation or #Decolonization)

- Topic analysis with word clouds, word pairs and with Machine-Learning based Topic Modeling etc. (with several R packages as rtweet, quanteda etc.)

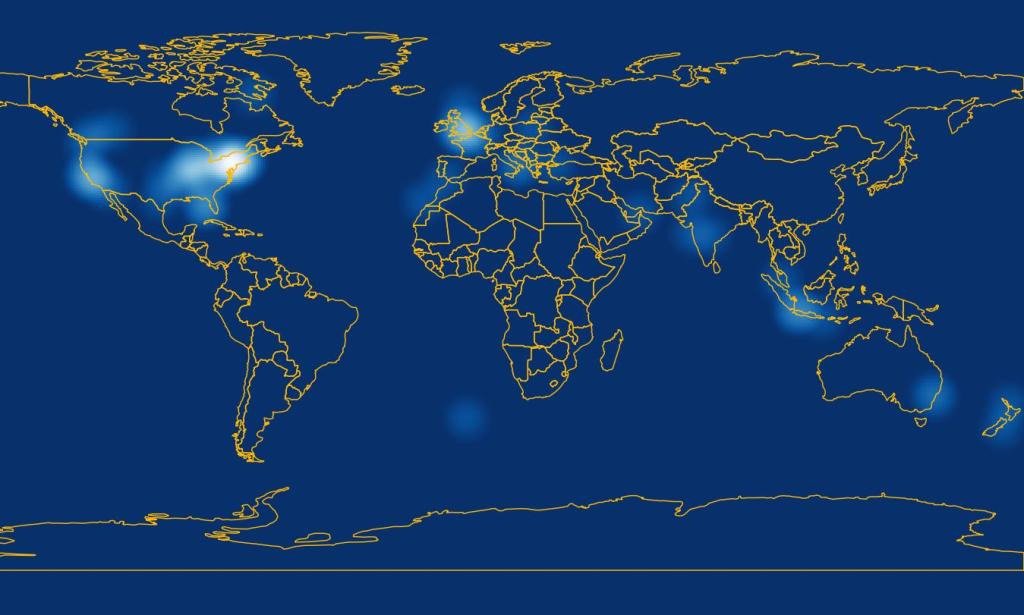

- Geocoding (i.e. longitude/latitude) the tweets and creating world maps with the regional distribution of tweets about several topics all over the world (with GIS-Software QGIS)

- Machine-learning-based Sentiment analysis (positive/negative) and emotion analysis (emotional states)

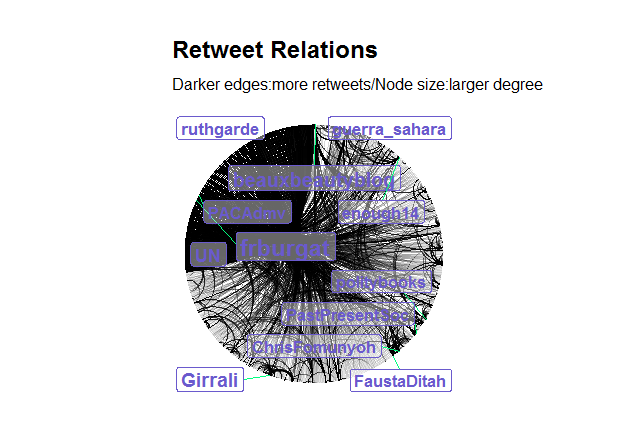

- Social network structure (SNA) etc. with the software NodeXL, Gephi and R packages

#Decolonisation

Analysis of tweets on Twitter with these hashtags / search terms:

#decolonization, #Kolonialismus, #colonisation, #decolonize, #decolonisation and #colonization

The Analysis contains social network analysis (and influcencer analysis), geolocation of tweets, topic and sentiment analysis. We colected 1602 tweets at Dec. 9th 2020 via R package rtweet form Dec. 1st to Dec. 9th, 2020.

The following chart shows the distributin of tweets over nine days.

Gelocations (map made with QGIS)

The „hotspots“ of tweets are in North America, Central Europe; less in Brazil and South Asia and not in Africa.

The social network analysis shows a retweet relationship in Circular Layout. Darker edges means more retweets, and node size is a larger degree.

Topics of the main tweets analyzed by sentiment (positive/negative).

The word cloud shows shows all topics with a positive and negative sentiment.

The word network analysis shows the related topics/word:

Sentiment and classification of mood according „Wheel of Motion“ from Pluchik.

Here you can find the mood classification with related topics:

And at the end you find an analysis about the frequencies of related search terms in Google Trend Analysis over time.

zurück zur Hauptseite:

https://mediaresearchinstitute.wordpress.com/

#ConspiracyTheory

(Oktober ’20)

– Social Network Analysis: Influencer

– Sentiment Analysis

– Geolocation

– Word Cloud (positive & negative)

– Word Pairs

#TwitterResearchProject

Analysis of Twitter data with tweets about #photography. A visualization of social network analysis of Twitter users with the software #Gephi

See video on YouTube

https://studio.youtube.com/video/SxEaxeKsTQk

Electroencephalography

in Media Research

zurück zur Hauptseite:

https://mediaresearchinstitute.wordpress.com/

#YouTubeResearchProject:

- Searching and analyzing tweets about special cultural or political topics (i.e. hashtags about Decolonisation) on You Tube

- Sentiment analysis, word clouds, word pairs etc. (with several R packages as rtweet, gtrendR etc.)

- Geocoding (i.e. longitude/latitude) the tweets and creating world maps with the regional distribution of tweets about several topics all over the world (with GIS-Software QGIS)

- Analyzing the social media network structure, topics, sentiments etc. with the software NodeXL, Gephi and R packages

zurück zur Hauptseite:

https://mediaresearchinstitute.wordpress.com/

Sozialdaten-Atlas

dA(R)Ta science

Brain Waves in photography perception

- Analyzing brainwaves with Muse 2 Headband during watching pinhole photography

The Photography

The Brainwaves

The Interpretation of the Brainwaves

| Gamma (γ) | greater 35 Hz | Concentration, higher mental activity and consolidation of information |

| Beta (β) | 12–35 Hz | Actively thinking, external attention, problem-solving |

| Alpha (α) | 8–12 Hz | Very relaxed, passive attention |

| Theta (θ) | 4–8 Hz | Deeply relaxed, inward focused, visualization |

| Delta (δ) | 0.5–4 Hz | Sleep |

zurück zur Hauptseite:

https://mediaresearchinstitute.wordpress.com/

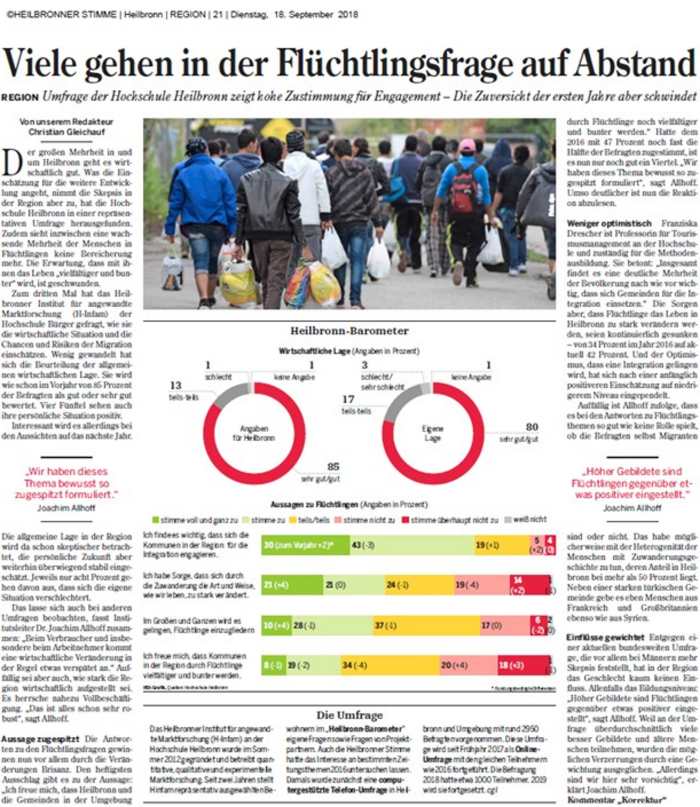

Survey Research

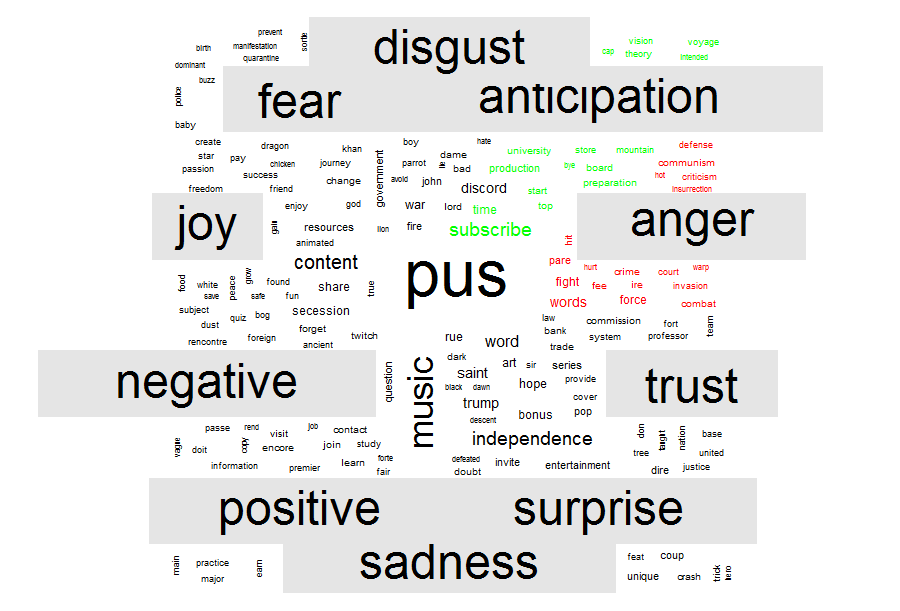

Attitudes toward Refugees – A German Case Study in Heilbronn

We’ve implented a panel survey in the city of Heilbronn from 2016 to 2019. And we measured the negative attitudes toward refugees with three items over four years:Q1: Step by step, it will be possible to integrate refugees in Heilbronn and surrounding area. (1 fully agree … 5 strongly disagree)

Q2: I think it is important that the city of Heilbronn and surrounding area are committed to the integration of refugees. (1 fully agree … 5 strongly disagree)

Q3: I am concerned that the immigration of refugees will change too much the way we live in Heilbronn and the surrounding area. (Recoded, (1 fully disagree … 5 strongly agree))

Within a stability model of attitudes toward refugees according to latent structure models (software Mplus from Muthen & Muthen ) we found following results:

(Factor loadings, measurement errors as well as item correlations are not given for reasons of clarity.

ATTENTION: No effect sizes, but stabilities! In terms of the linear logic of the SEM model, stability means that the mean of attidude toward refugees is constant from one measurement point to the next or increase by a constant amount for all respondents.

– High Stability of Attitudes 2016 to 2017 (.93) and 2017 to 2018 (.93)

– Strong change in attitude (from positive to negative or vice vers) from 2016 to 2018

(.02), from 2016 to 2018(-.18) and 2018 to 2019 (.25)

Model evaluation

ML estimation

Chi² Test: 35.99, Df 30, p = .208

RMSEA: .032 (90% CI: .000 / .066) SRMR: .021

CFI: .996

TLI: .992

N = 191 with 60 estimated parameters

The next model – a latent growth curve model – shows a test on

1. measurement invariance (factor loadings for items set equal)

2. linear growth of (negative) attiudes in the area of Heilbronn

We found – according our latent growth curve model a slightly, linear increase of negative attitudes toward refugees (with an starting latent mean 2.792 in 2016), an increase of the latent mean of .12 (2017) , .23 (2018) and .33 in 2019.

Model evaluation

ML estimation

Chi² Test: 63.64, Df 41, p=.013

RMSEA: .054 (90% CI:.025 / .079)

SRMR: .037

CFI: .987

TLI: .978

N=191 with 49 estimated parametern

zurück zur Hauptseite:

https://mediaresearchinstitute.wordpress.com/

—————————————————————————-

Customer Analytics für Unternehmen

Die Potentiale von Customer Analytics richtig nutzen

Mit dem Trendthema Big Data sind verschiedene Schlagwörter verbunden, wie zum Beispiel Data Governance, Visualisierung von Daten im Business Reporting oder Predictive Analytics. Was verbirgt sich aber hinter diesen Schlagwörtern? Wie kann man sich im Dschungel von Big Data und Analytics zurechtfinden; und welchen Weg sollte man als Unternehmen einschlagen, um die Potentiale von Data Analytics richtig zu nutzen? Im Folgenden wird ein standardisierter Bewertungsprozess aufgezeigt, wie Unternehmen den Aufbau von Customer Analytics planen und wie Maßnahmen eingeleitet und umgesetzt werden können, damit schrittweise der „Datenschatz“ gehoben wird.

Viele Unternehmen erhoffen sich laut einer Barc-Studie zunächst eine Verbesserung von Geschäftsprozessen und Verringerung von Prozesskosten durch die Implementierung von schnelleren Data Analytics Anwendungen. Im Fokus stehen hierbei einerseits die Anwendung von schnellen Analysemöglichkeiten durch Dashboards und die Visualisierung von Daten. Anderseits ist aber auch der Wunsch nach dem Einsatz von Prognose-Modellen („Predictive Analytics“) besonders stark – etwa zur Vorhersage von Kündigern oder zur Berechnung von Produktkaufwahrscheinlichkeiten. Insbesondere in diesem Bereich der Prognose-Modelle sehen Unternehmen Potentiale für die Senkung von Prozesskosten und die Verbesserung von Geschäftsprozessen. Als Hindernis wird aber unter anderem das Fehlen von fachlichem und technischem Know-how kritisch gesehen. Auch die konkrete Einbindung von Analytics Ansätzen in die betrieblichen Prozesse stellt häufig ein Hemmnis für die Nutzung von Big Data / Predictive Analytics-Ansätzen dar.

Mit der strategischen Zielplanung fängt alles an

Die Bewertung von Customer Analytics sollte immer die strategischen Ziele im Unternehmen, und daraus abgeleitet, die Ziele im Marketing und Customer Relations Management als Startpunkt nehmen. Dies beginnt mit den allgemeinen Geschäftszielen, die sich ein Unternehmen gesetzt hat (wie Steigerung des Umsatzes, Senkung von Betriebskosten und Einführung neuer Produkte). Die daraus abgeleiteten Ziele für Marketing- bzw. CRM-Abteilungen oder Data Mining-Teams sind dann ein zentraler Ausgangspunkt für die Bewertung und die weitere Nutzung von Customer Analytics Modellen. Ziele für CRM- oder Data Mining-Abteilungen können zum Beispiel die Entwicklung von Kundensegmentierungs-Modellen zur effizienteren Zielgruppenansprache oder die Erhöhung von Responsequoten von Direktmarketing-Maßnahmen sein (siehe Abbildung 1).

Abbildung 1: Planung und Umsetzung der Analytics Roadmap

Im nächsten Schritt wird dann ermittelt, welche Analytics-Ansätze zu welchen Zwecken bereits im Unternehmen eingesetzt werden und wie erfolgreich diese umgesetzt werden oder ob noch Verbesserungsansätze bestehen.

Am Anfang einer solchen Bestandsaufnahme und Bewertung steht immer eine Analyse des Datenmanagements. Hierbei werden vorhandene Daten auf ihre Qualität überprüft (zum Beispiel Befüllungsgrade oder Aktualität) sowie die Vollständigkeit von Daten in den Bereichen wie Kaufdaten, soziodemographische Daten, Daten zur Kanalnutzung, Responseverhalten auf Marketingaktionen oder mikrogeographische Daten ermittelt.

Weiterhin stehen dann die eigentlichen Analytics Ansätze wie Kundenstrukturanalysen, Kundenwert-Modelle (ABC-Analysen oder weiter entwickelte Kundenmodelle) an. Darüber hinaus zählt aber auch die Ermittlung von Ansatzpunkten für mögliche Verbesserungen zu dieser Ist-Analyse.

Auf Basis dieser Bestandsaufnahme kann der Reifegrad einzelner Ansätze sowie der Gesamtreifegrad im Bereich Customer Analytics ermittelt werden. Dieser lässt sich in folgende Analytics Reifegrade einteilen:

- Keine Anwendung von (Ad-hoc-)Kundenanalysen

- Unregelmäßige Ad-hoc-Analysen / Kunden-Analysen mit einfachen Analytics-Ansätzen (einfache Kunden ABC-Analysen)

- Regelmäßige Kundenanalysen mit einfachen Analytics-Ansätzen

- Regelmäßige Kundenanalysen mit teilweise komplexen Analytics-Modellen (Scoring-Modelle, Kundenwertprognose-Modelle)

- Kontinuierliche Analysen mit komplexen Modellen

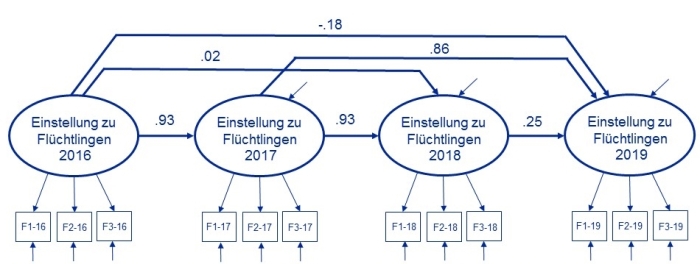

Um den Reifegrad der Customer Analytics-Ansätze in einem Unternehmen zu ermitteln, hat es sich bewährt, die beteiligten Abteilungen in die Bewertung mit einzubeziehen. Im Rahmen von Workshops und Interviews kann so eine valide Bestandsaufnahme der Customer Analytics-Aktivitäten abgebildet werden. Daran anknüpfend können dann die Zielperspektiven – im Rahmen dieser Workshops und Interviews – ermittelt und konsolidiert werden. Die Ergebnisse der Ist-Aufnahme und der Soll-Perspektive können dann in einem Netzwerkdiagramm zur Soll- und Ist-Situation anschaulich dargestellt werden.

Abbildung 2: Netzwerkdiagramm

Analytics Ansätze im Überblick

Im nächsten Schritt müssen dann die verschiedenen Analytics-Ansätze daraufhin überprüft werden, wie diese konkret zur Zielerreichung beitragen können. Abbildung 3 gibt einen Überblick über zentrale Analytics-Bausteine und deren jeweiligen Nutzen. Das Spektrum dieser Ansätze umfasst Ad-hoc-Analysen, Kundenwert-Modelle oder Kundensegmentierungen, Prognose-Modelle bis hin zu Social Media Analytics und mikrogeographische Analysen.

Schließlich erfolgt dann eine Gap-Analyse: Im Mittelpunkt steht hier, welche Modelle vorhanden sind (und mit welchen Verbesserungspotentialen) und welche weiteren Analytics-Modelle für die Erreichung der Zielsetzungen notwendig sind. Diese Lücken gilt es dann zunächst aufzuzeigen und einen Prozess zu entwickeln, wie diese Lücken durch den Einsatz neuer Modelle, Weiterentwicklung der Datenqualität, Einpflegen von neuen Kundendaten, usw. geschlossen werden können.

Abbildung 3: Analytics Ansätze und Nutzen

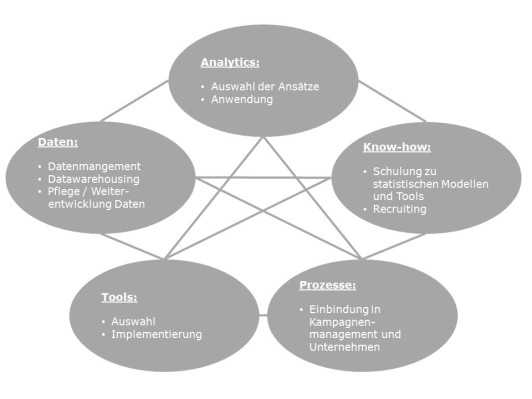

Entwicklung und Umsetzung einer Analytics Roadmap

Schließlich steht dann als weiterer wichtiger Schritt die Entwicklung und Umsetzung der Roadmap an (Vergleiche hierzu auch Danet Vesset, Henry Morris: The CIO’s Chance of a Lifetime – Using Big Data and Analytics as the Ticket to Strategic Relevance, International Data Corporation (IDC), Framingham, 2014; Michele Chambers, Thomas W. Dinsmore: Modern Analytics Methodologies – Driving Business with Analytics, Upper Saddle River, 2015; Vijay Kotu, Bala Deshpande: Predictive Analytics and Data Mining, Amsterdam; 2015): Hierbei sind fünf wesentliche Aspekte zu beachten, die miteinander in Beziehung stehen (siehe Abbildung 4):

- Auf der Grundlage der Gap-Analyse kann ermittelt werden, welche Analytics-Ansätze zur Zielerreichung beitragen und welche vorhandenen Ansätze weiter ausgebaut werden können. Daraus lässt sich dann ableiten, welche Ansätze eingeführt werden und welches Ergebnis diese Ansätze liefern sollten. Hierbei ist es aber besonders wichtig, nicht nur mittel- oder gar langfristige Ziele zu verfolgen. Sondern auch, mit den Analytics Ansätzen kurzfristige Vorteile zu erzielen („Quick wins“). Prinzipiell gilt: Es ist besser, mit wenigen ausgewählten Maßnahmen zu starten und diese umzusetzen, als sich zu viel vorzunehmen. Daher muss die Abfolge der einzusetzenden Ansätze genau geplant werden, aber auch die zeitliche Komponente berücksichtigt werden.

- Damit einhergehend sind dann in der Regel auch Maßnahmen bezüglich des Datenmanagements So gilt es zu ermitteln, wie die Datenqualität verbessert werden kann, welche Daten noch in das Datawarehouse eingepflegt oder neu erhoben werden oder neue Merkmale aus vorhandenen Daten gebildet werden müssen.

- Darüber hinaus ist auch die Mitarbeiterentwicklung von Bedeutung. Diese kann kurzfristig durch Schulungen zu Statistik-Tools, Analytics Methoden und ihre Anwendung erfolgen. Mittel- bis langfristig kann auch der Teamausbau durch weitere Recruiting-Maßnahmen durchgeführt werden, um weiteres Know-how aufzubauen.

- Auch Fragen der Organisation und Einbindung von Analytics Ergebnissen in laufende Prozesse müssen geklärt werden. So ist zu überprüfen, wie die Analytics Prozesse in die allgemeinen Unternehmensprozesse eingebunden werden – wie Analytics Modelle in die Kampagnenplanung regelmäßig integriert werden oder wie regelmäßige Ad hoc Analysen in das allgemeine Business Reporting eingepflegt werden, usw.

- Letztendlich muss entschieden werden, welches der zahlreichen am Markt verfügbaren Analytics Tools für das Unternehmen am geeignetsten ist (falls noch nicht vorhanden), um die anstehenden und zukünftigen Analyseaufgaben möglichst kostengünstig, aber auch leistungsfähig umsetzen zu können. Wichtig sind hierbei einerseits die Funktionalitäten bzgl. der geplanten Analysemodelle. Andererseits aber auch die Einbindung und technische Implementation in die vorhandenen Systeme sind hier wichtige Entscheidungsfaktoren. Hier ist es wichtig, möglichst langfristig zu planen, damit auch zukünftige Anforderungen erfüllt werden können.

Abbildung 4: Zentrale Faktoren der Analytics Roadmap

Um einen Nutzen aus den gewonnenen Erkenntnissen der verschiedenen Analytics-Ansätze zu generieren, ist es schließlich auch zentral, die Ergebnisse zu messen, zu bewerten und die grundlegenden Ansätze und deren Nutzen im Unternehmen zu kommunizieren. Dies stellt oftmals eine große Herausforderung dar, da statistische Verfahren für viele Unternehmensangehörige eine „Black box“ darstellen. Daher ist es umso wichtiger, die beteiligten Abteilungen hinsichtlich der Anwendung und der Umsetzung statistischer Ansätze zu beraten.

Fazit

Im Customer Relations Management wird der Kunde zunehmend stärker in den Fokus gestellt. Wir beobachten derzeit einen Wandel von der produkt- zur kundenzentrierten Sichtweise. Um diesen Wandel konsequent voranzutreiben, müssen Unternehmen aber die vorhandenen Potentiale, die in den Kundendaten liegen und mit den Analytics Ansätzen verbunden sind, stärker nutzen.

Um Customer Analytics-Ansätze gewinnbringend einzusetzen, ist eine Bewertung der Ist-Situation und der Soll-Situation wichtig. Diese sollte zwingend auf der Grundlage von Business Zielen erfolgen. Im Anschluss kann dann eine Roadmap entwickelt werden, die die Implementierung verschiedener Analytics Ansätze aufzeigt. Die Umsetzung der Roadmap ist unter anderem davon abhängig, wie die Klippen der Organisation, der Teamentwicklung, des Tooleinsatzes, des Data Managements und der Einbindung in Unternehmensprozesse gemeistert werden. Zentral ist es hierbei auch, „Quick wins“ zu generieren und nicht nur auf langfristige Erfolge zu setzen. Langfristiges Ziel sollte es aber sein, Analytics in das Unternehmen zu integrieren, den Nutzen auszuschöpfen und Daten-getriebene Analysen erfolgreich einzusetzen. Gelingt dies, so wird Customer Analytics zu einem wichtigen Schalthebel für die Ertragssteigerung und Kostenoptimierung im Customer Relations Management in Ihrem Unternehmen.

________________________________

Market Research / Customer Insights: „Ein neues Manifest für die Insights-Branche“

Autor: Susan Schwartz McDonald, President & CEO, Naxion Thinking

Quelle: https://www.marktforschung.de/aktuelles/meinung/marktforschung/ein-neues-manifest-fuer-die-insights-branche/

Im Jahre 2019 gibt es einiges, woran unsere Branche krankt. Lassen Sie mich mit einem der wichtigsten Symptome anfangen. Wir haben uns von unseren eigenen Schlagworten benebeln und uns von unserer eigenen Überheblichkeit verführen lassen. Jede Disziplin nutzt solche wohlklingenden Schlagworte, um ihre Ideen zu verkaufen, aber unsere scheint dieses Vokabular selbst anpreisen zu wollen. Denken Sie einmal darüber nach, wie manche Mantras aus dem letzten Jahrzehnt unsere Diskussionen beherrscht, sie regelrecht an sich gerissen haben. Begriffe wie Semiotik und Heuristik, mit denen wir nur zu gerne hantiert haben, ohne dass sie substantiell etwas verändert hätten. Oder die Neurowissenschaft, die sich einst anschickte, das ganze Geschäft zu revolutionieren, aber nunmehr zu einem bloßen Winseln verkommen ist. Das ohrenbetäubende Trommeln rund um die Verhaltensökonomie, das nicht nur traditionelle Branchenkonzepte, sondern auch solche, deren praktische Relevanz seit langem bewiesen ist, in Verruf gebracht hat.

Dann wäre da noch die Verhaltensforschung – explizit von einer Branchenkonferenz als „das neue Schlagwort, das man unbedingt verstehen müsste“ angepriesen. Verhaltensforschung? Ein Allgemeinbegriff, mit dem Bildungseinrichtungen ihr gesamtes sozialwissenschaftliches Curriculum überschreiben?

Ich möchte hier nicht die Spielverderberin sein, aber hier kommt die Wahrheit: Es nervt mich und ich kann es nicht mehr hören. Wir müssen einfach damit aufhören, bloße Sprachakrobaten zu sein, die irgendwelche Schlagwörter für sich vereinnahmen und umfunktionieren, nur um damit Aufmerksamkeit zu erregen. Und wir müssen aufhören, an Wörter und Begriffe zu glauben, die nicht das volle Vertrauen unserer Branche genießen. Es ist schwer genug, die realen Veränderungen zu managen. Wir bringen diesen Prozess nicht voran, wenn wir bloß am Phrasenrad drehen.

Wer sind wir und was machen wir eigentlich hier?

Wenn die vielen Schlagworte ein Symptom darstellen, worin besteht dann die Krankheit? Der überwältigenden Aufgabe der „Innovation“ gerecht zu werden – ein weiteres dieser Worte, das wir viel zu oft hören. Natürlich sind gerade eine Menge echter technologiebasierter Veränderungen im Gange, die neue Fähigkeiten und neue Geschäftsmodelle erfordern. Aber mit diesen außergewöhnlichen Ressourcen gehen auch außergewöhnliche Anforderungen einher. Die Forderung, alles schneller, besser und günstiger (am besten alles zusammen) zu machen, macht es uns aber auch schwer, es gut zu machen.

Dieses Gefühl der absoluten Dringlichkeit führt einen oft zu der Annahme, dass wenn man die Dinge nicht gänzlich anders anpackt als gestern noch, man sehr schnell als obsolet gilt, abgehängt von der veränderungswilligen Konkurrenz. Und wenn man sich nicht wirklich verändern kann, kann man den Dingen immer noch neue Namen geben.

Wir befinden uns nicht nur auf der Suche nach neuen Schlagworten, wir befinden uns auf der Suche nach uns selbst. Riesige neue Datenquellen erlauben es uns, Marktforschung als einen Vorgang des Beobachtens und Belauschens statt des Befragens umzudefinieren, was wiederum eine wachsende Ernüchterung hinsichtlich der grundlegenden Prämisse der Umfrageforschung vorantreibt: die Idee, dass man Leute zu dem befragen kann, was sie denken und dass man erwartet, eine ehrliche (oder brauchbare) Antwort zu erhalten. Während wir dabei sind, unser intellektuelles Zuhause einer Generalüberholung mit ganz neuen Arten von Daten und viel größeren Maßstäben zu unterziehen, ist nicht immer klar, wo der alte Kram noch hinpasst. Viele Datenanbieter möchten uns glauben machen, dass es nicht so wichtig ist zu verstehen, warum Menschen gewisse Dinge tun, wenn man stattdessen soviel mehr davon beobachten kann, was sie tatsächlichen tun. Wir haben es hier nicht nur mit Veränderungen zu tun, sondern mit einer handfesten Identitätskrise der Branche.

Homo Habilis. Die besten Tools

Kein Wunder also, dass wir uns in Widersprüchen verfangen haben. Trotz des erklärten Branchenziels, strategische Beratung auf Basis von Synthese und Interpretation anzubieten, kommt unser Anspruch auf Relevanz im 21. Jahrhundert erstaunlich toolzentriert daher. Auf Firmenwebseiten wird bestimmten „Ansätzen“ mehr Platz eingeräumt als je zuvor. Ironischerweise kann gerade dieser destruktive Fokus auf Tools neue Hindernisse für die Datenintegration und eine schlüssige Entscheidungsfindung heraufbeschwören. Wir gefährden genau die Sache, die wir alle anstreben – nämlich die besten Ideen – dadurch, dass wir uns mit schlagwortgesättigten Debatten über die besten Tools ablenken.

Denn es ist durchaus von Bedeutung, wie wir über Dinge reden – im Geschäftsdiskurs ebenso wie in der Politik. Unpräzise Begrifflichkeiten machen es einem nicht gerade leicht, einen festen Zugriff auf neue Ideen zu bekommen. Denken Sie an Machine Learning – ein ziemlich dehnbarer Begriff, den man mit gutem Recht dafür nutzen kann, um bestimmte Formen der Regressionsanalyse zu beschreiben. Genau deshalb wird er immer wieder ins Felde geführt, um Marktforschungsanwendungen damit smarter und glaubhafter erscheinen zu lassen, als sie es eigentlich sind. Selbst der Begriff Data Science wäre vielleicht zu übertrieben für das Allermeiste, was wir tun. Um den Mars mit der Voyager zu erreichen, braucht es echte Wissenschaft. Um authentische und profitable Insights mittels eines komplexen Driver-Modells zu erhalten, braucht es vermutlich mehr Kunst.

Verbessern wir unsere Tools und unsere Sprache, um echte Innovation zu ermöglichen

Gewiss muss die Insights-Branche mit Innovationen auf diese neue Situation reagieren – aber es wäre unrealistisch, wenn wir genauso schnelle und konsequente Fortschritte in den statistischen Techniken erwarten würden, die wir nutzen, um menschliches Verhalten zu erklären und vorauszusagen. Innovationen in den Neurowissenschaften und der Verhaltenstheorie schreiten deutlich langsamer voran als unsere alltäglichen Datenströme und unsere Modelle haben Mühe, mit den extrem schnellen kulturellen Anpassungen, die jede Voraussage nach wie vor schwer machen, Schritt zu halten. Es war immer schon schwierig, die Varianz in Verhaltensdaten vollständig zu erklären. Diese frustrierende Wahrheit wird vermutlich auch weiterhin Bestand haben, egal wie sehr wir unsere Tools mit Machine Learning aufmöbeln oder uns künstlicher Intelligenz unterwerfen.

Home Sapiens. Die besten Insights

Vielleicht, muss man fairerweise sagen, ist es genau das, worum es bei unserer Zurück-in-die-Zukunft-Nostalgie für angestaubte Begriffe wie Verhaltensforschung geht. Wir krallen uns an Tools und Begrifflichkeiten, weil sich das einfacher anfühlt, als der viel langsamere, schwierigere Vorgang, über Daten nachzudenken, um Geschäftsprobleme zu lösen.

Wir alle wissen genau, was uns dazu gebracht hat, uns dieses Wort „Insights“ auf die Fahne zu schreiben – zunächst als unseren Schlachtruf, dann als Werbebanner für eine Unternehmensfunktion und schließlich als Name für eine gesamte Branche. Aber indem wir es überstrapazierten, hat sich das Wort entwertet. Wenn wir ehrlich zu uns sind, müssen wir uns eingestehen, dass jede neue Sache, die wir herausfinden und sei es nur ein Driver-Modell- Koeffizient, heute als Insight bezeichnet werden kann. Genauso wie jede kleine Kerbe in unserem Werkzeugkasten als Innovation verkauft wird.

Wenn wir darüber nachdenken, wie wir die Gesundheit und den Wert der Branche verbessern können, sollten wir folgende Dinge berücksichtigen. Sicherlich sind sie ehrgeizig, aber so sind schließlich alle wahren Insights. Die Zukunft unserer Branche steht auf dem Spiel.

Wir brauchen eine größere Transparenz der Ideen und eine größere Klarheit in der Begrifflichkeit

Wir werden es nicht weit bringen, wenn wir alte Begriffe verhökern oder innovative Wörter auf Ideen kleben, die wir nicht gründlich genug geprüft haben. Echte technische Fortschritte sind ein Grund zur Begeisterung – aber wir müssen auch meinen, was wir sagen.

Wir benötigen mehr Forschung über die Marktforschung selbst und außerdem mehr Einsatz, diese auch zu verbreiten und bekannt zu machen.

Obwohl es handfeste Herausforderungen im Bereich des gemeinschaftlichen Lernens in Geschäftsumgebungen gibt, existieren trotzdem beträchtliche Chancen für Unternehmen, Initiativen selbst zu finanzieren, die tatsächlich neues Wissen generieren können. Das umfasst die Zusammenarbeit zwischen Kunden und Agenturen genauso wie zwischen Agenturen mit komplementären Daten- und Skillsets, deren gemeinsame Kraft nur durch kreative Zusammenarbeit freigesetzt werden kann. Wir müssen ebenso lernen, von jenen Plattformen besseren Gebrauch zu machen, die uns für den Ideenaustausch zur Verfügung stehen. Optimale Vorgehensweisen (Best Practices) können wir nur vorantreiben, wenn wir unseren Wert im Rampenlicht öffentlicher Debatten unter Beweis zu stellen vermögen.

Wir müssen unangenehme Fragen über die Umfrageforschung zulassen, um das wiederherzustellen und zu bewahren, was von einzigartigem Wert an ihr ist

Um die Vertrauenskrise in der Umfrageforschung zu überwinden, müssen wir uns einiger ihrer Grundprinzipien besinnen, sodass wir sie selbst besser beherrschen. Des Weiteren bedarf es einer gemeinsamen, branchenweiten Anstrengung, um die Quote und Qualität des Rücklaufs zu verbessern. Das ist eine ebenso herausfordernde wie wichtige Aufgabe. Im Falle einiger zentraler Anwendungen gibt es einfach keinen Ersatz dafür, von Leuten zu hören, „was sie glauben zu wissen.“ Es würde einen riesigen Verlust für unsere Branche darstellen, wenn die kommende Generation von Insights-Experten davon nicht mehr überzeugt wäre.

Wir müssen lernen, die Datenbanken besser zu verstehen, mit denen wir in Zukunft arbeiten wollen

In zu vielen Kundenorganisationen besteht ein riesiger Graben zwischen jenen, die Datenbanken verwalten und jenen, die dafür verantwortlich sind, diesen Insights zu entlocken. Das hat zu schlechter Kommunikation und Missverständnissen darüber geführt, was verschiedenste Datenbaken beinhalten und wie sie strukturiert sind. Und die Dinge stehen meist nicht besser (oft viel schlechter), wenn wir uns außerhalb der jeweiligen Unternehmen umschauen, um externe Datenquellen anzuzapfen. Wenn wir tatsächlich neue und ehrgeizige Ziele mit Big Data verfolgen, benötigen wir nicht nur profunde Fähigkeiten, mit Datenbanken umzugehen, sondern ebenso eine vollständige Transparenz existierender Datenbanken. Wir müssen das Konzept der Big Noise zusammen mit Big Data schätzen lernen. Wir können uns nicht allein auf die Größe von Datenbanken verlassen.

Wir müssen überdenken, was wir unter Datenintegration verstehen und was wir tatsächlich unternehmen können, um diese zu erreichen

Datenintegration ist ein wenig wie das Wetter – jeder spricht darüber, aber niemand kann irgendetwas dagegen tun. Wir dürfen uns Datenströme nicht als Zutaten vorstellen, die wir in einen Topf werfen und mit einer Prise künstlicher Intelligenz schmoren lassen. Haben wir erst einmal erkannt, dass bei verschiedenen Datenbanken strukturelle Ausrichtungsfehler bestehen, müssen wir uns darum bemühen, diese zu vereinheitlichen – oder zu dem Schluss kommen, dass sie in verschiedenen Töpfen einfach besser schmecken.

Wir brauchen besser ausgebildete und besser geschulte Fachkräfte sowohl aus den Sozialwissenschaften als auch aus dem Businessbereich

Business Schools haben sich in den 1980ern die Verantwortung für die Marktforschung von den Sozialwissenschaften angeeignet, aber ein zweijähriges Wirtschaftsstudium lässt nicht mehr zu, als das Thema Marktforschung einmal kurz anzuschneiden. Wir müssen wieder nach Impulsen aus den Sozialwissenschaften umschauen und das nicht bloß, indem wir Phrasen dreschen, sondern indem wir die fruchtbaren Verbindungen mit den wissenschaftlichen Disziplinen und Einrichtungen wiederherstellen, aus denen unsere Branche einst erwachsen ist. Es ist an der Zeit, „Kundenpsychologie“ als ein ernsthaftes Forschungsfeld wieder aufleben zu lassen.

Wir müssen das Wort „Insight“ überdenken und es mittels intellektueller Neugier mit neuem Leben erfüllen

Insights – dieses Wort umwehte einmal die Vorstellung von so etwas wie einer tiefen, glitzernden Erzader von Kundenerkenntnissen, die, wenn man sie erst einmal ausgegraben hat, wirklich und nachhaltig etwas in unseren Unternehmen zu bewirken vermochten. Mit seinem inflationären Gebrach hat das Wort allerdings auch seinen alten Glanz eingebüßt. Wir können die Zeit natürlich nicht zurückdrehen, aber wir können das Wort am Leben erhalten, indem wir es sparsamer gebrauchen. Wir müssen danach streben, das „Warum“ und nicht bloß das „Was“ und das „Was als nächstes“ im menschlichen Verhalten zu begreifen. Und wir müssen unsere Ohren nach überallhin offen halten, kulturelle Informationen aus allen möglichen Quellen abzapfen, um einen Kontext zu schaffen, in dem wir unsere Forschungsdaten interpretieren können. Wahre Erkenntnis (Insight) ist das Ergebnis von Synthese und Reflexion, nicht allein von analytischer Automatisierung.

Damit all dies passieren kann, müssen wir dem Wort Analyse wieder zu seinem alten Glanz verhelfen, unmittelbar an der Seite von Analytics, was es in der Vergangenheit viel zu oft ersetzt hat. Wann immer ich mit jungen Branchenfachleuten ins Gespräch komme, singe ich ein Loblied auf die Tugenden der intellektuellen Neugier. Erkenntnis, ebenso wie Inspiration, bevorzugt jene Köpfe, die am besten auf sie vorbereitet sind.

—————————————————————————-

Kommunikations-Controlling für Unternehmen

Wie Unternehmen Marketing und Kommunikation gleichzeitig steuern können

Dieser Beitrag stellt einen Ansatz vor, der alle wesentlichen Kommunikationsinstrumente miteinander vereint und im Rahmen eines Stufenmodells entsprechende Kennziffern verortet, um ein umfassendes Kommunikations-Controlling zu ermöglichen.

In den letzten Jahren haben Ansätze zum Marketing- bzw. Kommunikations-Controlling zunehmend an Bedeutung gewonnen. Dies liegt unter anderem sicherlich daran, dass die Medienlandschaft mit Internet- und insbesondere Social Media-Angeboten die Steuerbarkeit von Marketingkommunikation grundlegend verändert hat. Die zentralen Ziele der Unternehmens- und Produktkommunikation sind zwar nach wie vor Unternehmen oder Produkte / Dienstleistungen

- bekannt zu machen (Awareness),

- positiv zu darzustellen (Image/Reputation),

- Alleinstellungsmerkmale herauszustellen (Unique Selling Position, USP)

- und somit eine Kaufbereitschaft bzw. eine Marken-/ bzw. Unternehmenssympathie herzustellen.

Gleichzeitig hat sich aber das Kommunikationsverhalten von Zielgruppen fundamental geändert. Chancen bieten einerseits die Vielzahl der klassischen und neuen Kommunikationskanäle sowie eine möglichst zielgruppengenaue Kommunikation. Damit sind aber auch andererseits Risiken bzw. Unwägbarkeiten in der Kommunikation verbunden. So ist eine direkte Beteiligung der Zielgruppen möglich, in der die beabsichtigte Wirkung der Kommunikation nur schwer vorhersehbar wird. Die klassische eindimensionale Kommunikation (Sender – eindeutige Botschaft – Empfänger) hat sich zu einer Netzwerk-Kommunikation weitergebildet, in der die Kommunikation eben nicht mehr eindeutig von Unternehmen beinflussbar ist.

Viele Kennzahlen im Marketing, die insbesondere von der Marktforschung geliefert werden sollen, sind häufig auf eine Unterstützung kurzfristiger Marketing-Mix-Entscheidungen gerichtet und nicht langfristig angelegt. Umfassende Anwendung von Kennzahlensystemen im Marketing- und Kommunikationsmanagement findet häufig noch nicht statt. Gleichzeitig wächst aber auch die Erwartung an Marketing- und Kommunikationsabteilungen, Leistungsnachweise für Kommunikationserfolge zu erbringen und auch die Budgetverteilung zu rechtfertigen.

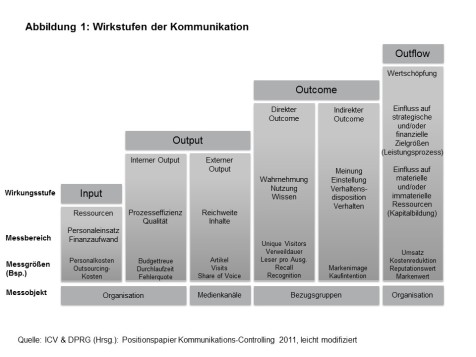

Deshalb wird es zunehmend wichtig, die Wirkung von verschiedenen Kommunikationskanälen umfassend zu beobachten und zu bewerten. Im Rahmen des Kommunikationsmanagement hat sich insbesondere ein Ansatz zum Kommunikations-Controlling im Public Relations Bereich durchgesetzt, der sich für alle Bereiche der Unternehmens- und Marketingkommunikation eines Unternehmens oder einer Organisation einsetzen lässt. Dieses integrierte Modell des Controlling für die Kommunikation wurde von der Deutschen Public Relations Gesellschaft (DPRG) und dem Internationalen Controller Verein (ICV) entwickelt und beschreibt verschiedene Wirkungsstufen der Kommunikation (siehe Abbildung 1).

Dadurch wird es möglich, mit Hilfe von zentralen Indikatoren die gesamten Kommunikationsmaßnahmen von der PR-Abteilung bis zur Marketing-Abteilung zu bewerten. Dieser Ansatz soll im Folgenden vorgestellt und anhand von einigen Beispielen illustriert werden. In diesem Wirkstufen-Modell lassen sich dann klassische Marktforschungsmethoden mit Methoden der Medienanalyse sowie mit Web- und Social Media- Analytics kombinieren.

Wirkstufen-Modell der Kommunikation

Das Modell unterscheidet verschiedene Wirkungsstufen. Mit diesen Stufen werden gleichzeitig verschiedene Indikatoren / Key Performances Indikatoren (KPI) beispielhaft dargestellt, mit denen die Wirkung in jeder einzelnen Phase bzw. Wirkstufe gemessen werden kann.

- Input

Diese Stufe umfasst die Ressourcen, die für die verschiedensten Kommunikations-maßnahmen eingesetzt werden. Messbereiche sind dann der Personalaufwand und Ressourceneinsatz.

Kennzahlen in diesem Bereich können entsprechend dann Personalkosten (ggf. pro Projekt) und Outsourcingkosten wie Druckkosten, Agenturkosten usw. sein. - Output

Diese Stufe wird unterschieden in interner Output (Prozesseffizienz und Kosteneffizienz, Qualität) und externer Output auf der Ebene von Medien- und Kommunikationskanälen (Reichweite, Inhalte).

Kennzahlen für den internen Output können unter anderem Budgettreue, Fehlerquote oder Durchlaufzeit bzw. Bearbeitungszeit darstellen. Für den externen Output können dann die Anzahl erschienener Artikel/Medienberichte, Visits bzw. Page Impressions oder Medienberichte im Wettbewerbsvergleich (Share of Voice) sein.

Zunehmend werden aber natürlich auch Social Media Kanäle wichtig. Übliche wichtige Kennzahlen sind Tweets/Retweets, Follower, Likes, etc. - Outcome

Auch diese Stufe wird unterteilt nach direktem und indirektem Outcome. Der Messbereich des direkten Outcomes umfasst- die Wahrnehmung von Kommunikationsmaßnahmen,

- die Bekanntheit bzw. das Wissen um bestimmte berichtete Unternehmensaspekte oder beworbenen Produkte sowie

- die Nutzung (von Produkten und Dienstleistungen).

Kennzahlen für den direkten Outcome sind z.B. Unique Visitors, Verweildauer auf einer Webseite, Leser pro Ausgabe sowie gestützte und ungestützte Bekannheit.

Der Messbereich des indirekten Outcomes umfasst z.b. Meinungen, Einstellungen sowie Handlungsabsichten.

KPIs in dieser Wirkstufe sind z.B. das Markenimage, das Unternehmensimage oder Kaufabsichten oder auch Produktbesitz/Nutzung.

4. Outflow

Die letzte Wirkstufe diesem Modell ist schließlich der Outflow bzw. die erzielte Wertschöpfung der verschiedensten Kommunikationsmaßnahmen. Messbereiche sind hier einerseits der Einfluss auf strategische und finanzielle Zielgrößen (KPIs: Umsatz, Kostenreduktion, Marktanteile etc.). Anderseits umfasst diese Stufe Einflussgrößen auf materielle und immaterielle Zielgrößen (KPIs: Markenwert und Reputationswert u.a.)

Zielgruppen-Orientierung

Im Rahmen eines umfassenden Kommunikations-Controlling sind die relevanten Zielgruppen der Kommunikation von zentraler Bedeutung. Denn unterschiedlichen Zielgruppen bedeuten auch entsprechend unterschiedliche Kommunikationsziele, -strategien und –inhalte.

In Abbildung 2 sind die unterschiedlichen Bezugsgruppen der Kommunikation systematisch nach verschiedenen Märkten dargestellt. Es werden hier die verschiedenen „Kommunikationsmärkte“ nach Ressourcenmarkt (Mitarbeiter usw.), nach Absatzmarkt (z.B. Kunden), nach Akzeptanzmarkt (z.B. Medien, Politik usw.) und schließlich Finanzmarkt (Aktionäre usw.) unterschieden. Diese Zielgruppen müssen im Rahmen der Kommunikationsstrategie festgelegt sowie auch unterschiedliche Kommunikationsziele pro Gruppe definiert werden.

Strategie/Implementierung

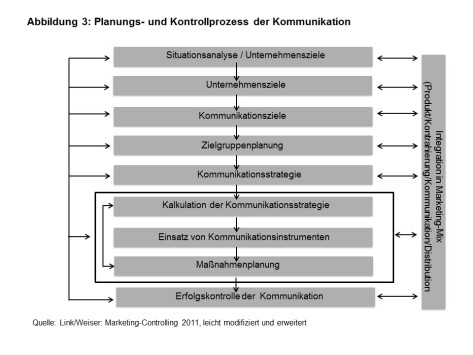

Von zentraler Bedeutung für ein erfolgreiches Kommunikations-Controlling ist die Einbindung der gesamten Unternehmens- und Marketingkommunikation in einer Kommunikationsstrategie.

Die Kommunikationsziele sollten aus der allgemeinen Unternehmensstrategie abgeleitet werden (Marketing-Aktionen, PR-Maßnahmen usw.). Diese Ziele müssen dann für die einzelnen als wichtig erachteten Zielgruppen abgestimmt werden. Auch die regelmäßige Erfolgskontrolle mit Hilfe geeigneter Indikatoren muss in diese Strategie eingebunden werden. Mit Hilfe der Ergebnisse dieser Erfolgsmessung können dann Anpassungen der Instrumente, Maßnahmen oder Zielgruppenplanung erfolgen (siehe das ideale Ablaufschema für die Kommunikationsstrategie in Abbildung 3).

Entscheidend für den Erfolg der Strategieumsetzung ist neben diesen inhaltlichen Planungen aber auch die organisatorische und personelle Einbindung aller relevanten Abteilungen wie PR-Abteilung und Marketingabteilung. Dies ist jedoch bei vielen Unternehmen bislang noch nicht gegeben. Aber erste eine einheitliche und abgestimmte Kommunikation mit den verschiedensten Kommunikationsinstrumenten ermöglicht die Umsetzung einer umfassenden Kommunikationsstrategie und entsprechend auch des Kommunikations-Controllings.

Anwendungsbeispiele

Gemäß dem Wirkstufen-Modell der Kommunikation können in den unterschiedlichen Stufen unterschiedliche Kennzahlen zum Controlling eingesetzt werden. Im Folgenden konzentrieren wir uns auf die Stufen Output / Outcome. Insbesondere in diesen Stufen können Kennzahlen aus Ansätzen von Marktforschung, Medienmonitoring, Social Media-Analytics und Web Analytics angewendet werden. Das Medienmonitoring lässt sich dann in der Stufe „externer Output“ verorten. Marktforschung sowie Web und Social Media-Analytics können für die Wirkstufen „direkter und indirekter Outcome“ eingesetzt werden.

Beim Medienmonitoring werden quantitative und qualitative Ansätze unterschieden. Beim quantitativen Medienmonitoring werden die Anzahl der Beiträge zu bestimmten Themen, die Medienarten sowie die entsprechenden Auflagen, Reichweiten, Visits und so weiter ermittelt. Mit Hilfe dieser Methode lässt sich dann die quantitative Medienberichterstattung im Zeitverlauf analysieren (s. Abbildung 4).

Die inhaltsanalytische Auswertung von klassischen und neuen Medien wird immer nach einer bestimmten methodischen Vorgehensweise durchgeführt:

- Suchprofil (Suchbegriffe)

- Festlegung eines Kategorienschemas (Themen etc.) und eines Codebuchs

- Auswahl wichtiger Medien oder Komplett-Auswertung von Zeitungen und Zeitschriften, Radio- und TV-Stationen, Online-Seiten und Social Media

- Schulung von Codierern, Probecodierungen und Reliabilitätstests (und anschließend ggf. Überarbeitung des Codebuchs)

- Monitoring der klassichen und neuen Medien

- Auswertung / Codierung mit Hilfe klassischer Inhaltsanalysen

- Statistische Aufbereitung

Beim Monitoring und der Analyse von Social Media-Kanälen werden Social Media Monitoring-Tools eingesetzt, die Social Media Plattformen wie Twitter, Facebook, Blogs, Foren usw. nach bestimmten Schlagworten durchsuchen und grafisch darstellen.

Hiermit sind auch automatische Auswertung der Bewertungsrichtung (sog. Sentiment Analysis) mit Hilfe von linguistischen Algorithmen möglich. Die Zuverlässigkeit nimmt aber mit zunehmender Komplexität eines Osts deutlich ab. Um hier kostengünstig und schnell zu manuellen und damit valideren Codierungsergebnissen zu gelangen, haben sich Stichprobenziehungen bewährt.

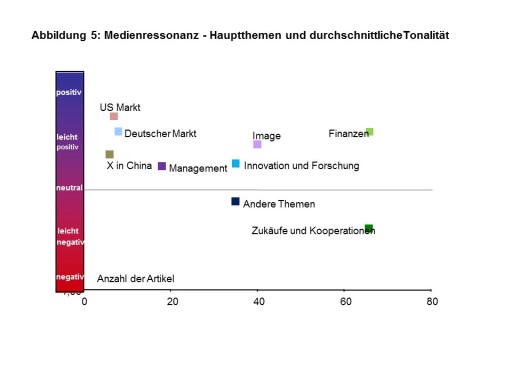

Bei der qualitativen Medienresonanzanalyse hingegen werden die Themen und Bewertungstendenzen der Berichterstattung ermittelt (sog. Tonalität).

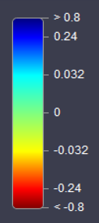

Die Bewertung der Medienberichterstattung wird häufig in fünf Abstufungen (sehr positiv (+1), eingeschränkt positiv (+0,5), neutral (0), eingeschränkt negativ (-0.5), eindeutig negativ (-1) codiert. Der Codierer vergibt also pro Aussage einen Code, wobei eindeutig festgelegt werden muss, welche Typen von Aussagen welche Bewertungen bedeuten. Umsatzwachstum des Unternehmens x wird dann z.B. als eindeutig positiv bewertet. Umweltbelastungen durch das Unternehmens sind als eindeutig negativ einzustufen (siehe Abbildung 5). Wichtig im Rahmen von Benchmarkanalysen ist auch das Einbeziehen von relevanten Wettbewerbern. Hier können dann etwa die durchschnittliche Tonalitäten der wichtigen Marktteilnehmer miteinander verglichen werden.

Die Anzahl der Medienberichte sowie die Bewertungsrichtung behandelter Themen können auch miteinander kombiniert werden. So ergibt sich eine Vierfelder-Matrix, in der positive und negative Medienberichterstattung mit den jeweiligen Themen sowie die Bewertungen abgetragen werden (siehe Abbildung 6). Besonderes Augenmerk verdienen dann Berichte mit einer hohen Anzahl von Artikeln und einer hohen Reichweite über negative Themenberichte. Auf dieser Grundlage können dann Handlungsempfehlungen abgeleitet werden.

Die quantitative und qualitative Analyse der Medienberichterstattung allein ist aber noch nicht ausreichend. Denn entscheidend ist weiterhin, wie die unterschiedlichen Kommunikationsmaßnahmen auf die relevanten Zielgruppen wirken. Hier kommen nun die klassischen Marktforschungs-Ansätze ins Spiel. Wichtige Kennziffern sind

- gestützte oder ungestützte Bekanntheit,

- Marken- oder Unternehmensimage,

- Nutzung von Produkten und Dienstleistungen (Marktanteile),

- Kaufabsichten,

- Weiterempfehlungsbereitschaft und

- Kundenzufriedenheit

Insbesondere Image- und Zufriedenheitsumfragen in verschiedensten Zielgruppen spielen eine wichtige Rolle beim Marketing- und Kommunikations-Controlling. Innerhalb der Image- und Zufriedenheitsforschung haben sich einige zentrale Indikatoren etabliert. Wichtige Fragen betreffen demzufolge die allgemeine Bewertung von Unternehmen, Produkten- oder Dienstleistungen sowie speziellen Faktoren wie Qualität und Preis-Leistungs-Verhältnis.

Für kleine Zielgruppen kommen insbesondere qualitative Einzelinterview mit einer geringen Anzahl von Befragten in Frage, zum Beispiel in Form von Stakeholder-Befragungen. Für Endkunden bieten sich häufig als geeignete Methode Online-Umfragen an. Somit lassen sich dann Image- und Zufriedenheitsprofile erstellen und gegebenenfalls Schwachpunkte analysieren. Auch hier hier ist es sinnvoll im Rahmen von Benchmark-Analysen Produkte und Dienstleistungen wichtiger Wettbewerber in die Umfragen zu integrieren.

Mithilfe unterschiedlicher Methoden können also in den verschiedenen Phasen der Kommunikation von Unternehmen zentrale Kennziffern erhoben werden, die Rückschlüsse auf die Wirkung der Kommunikation ermöglichen. Darauf aufbauend kann dann eine Weiterentwicklung oder auch eine Korrektur von Marketing- und Kommunikationsmaßnahmen erfolgen.

—————————————————————————-

Panel-Analyse in der Meinungsforschung

1. Berücksichtigen Sie bereits bei der Planung von Panelumfragen Ausfälle von Teilnehmern

Im Rahmen von Paneldesigns können im Laufe mehrerer Umfragezeitpunkte eine erhebliche Anzahl von Befragten abspringen. Daher müssen diese Ausfälle bei der anfänglichen Stichprobengröße unbedingt berücksichtigt werden oder Ausfälle entsprechend nachrekrutiert werden, damit eine ausreichende Fallzahl für die Analyse zur Verfügung steht.

2. Um Aussagen über Trends auf individueller oder kollektiver Ebene machen zu können, sind mindestens drei Zeitpunkte nötig

Eine stabile Trendentwicklung lässt sich erst nach mindestens drei Erhebungswellen innerhalb eines Paneldesigns ablesen; besser sind aber mehr Wellen. Dies gilt sowohl für Panel- als auch für Trend-Umfragen.

3. Panelwellen sollten in regelmäßigen und gleichen Abständen erfolgen

Bei der Analyse von Paneldaten, ist es sinnvoll, die Befragungen in regelmäßigen und gleichen Abständen durchzuführen. So lassen sich die Ergebnisse einfacher und eindeutiger interpretieren.

4. Beobachten Sie mögliche externe Effekte in der Medienberichterstattung

Um die Panelergebnisse besser einschätzen zu können, sollten Medienberichte über inhaltlich relevante Ereignisse beobachtet werden. So lassen sich Veränderungen besser einschätzen.

5. Stellen Sie sicher, dass immer die gleiche Person teilnimmt

Unabdingbare Voraussetzung für ein Paneldesign ist es, dass immer die gleichen Personen teilnehmen. Nur so lassen sich individuelle Veränderungen bei einzelnen Personen zuverlässig analysieren. Dies muss in der Panelanalyse kontrolliert werden.

6. Fehlende Werte von Personen bei einzelnen Fragen können ersetzt werden

Auch wenn Befragte kontinuierlich an der Umfrage über alle Umfragezeitpunkte teilnehmen, werden doch nicht immer alle Fragen innerhalb einer Welle beantwortet. Um trotzdem möglichst hohe Fallzahlen für die Datenanalyse zu nutzen, können diese fehlenden Werte ersetzt werden. Eine einfache Möglichkeit stellt dabei der Austausch eines fehlenden Wertes durch den Mittelwert der Variablen zu dem jeweiligen Befragungszeitpunkt dar.

7. Kausale Effekte sind auf Personenebene messbar

Durch die zeitliche Abfolge der Panelumfragen lassen sich quasi-experimentelle Designs erstellen, in denen die Stichprobe in Versuchs- und Kontrollgruppen eingeteilt werden können. Bestimmte Ereignisse, die nur auf die Versuchsgruppe wirken, lassen sich so auf ihre Effekte überprüfen.

8. Gängige deskriptiven Analysetechniken bieten einen schnellen Überblick

Die üblichen univariaten Analyseverfahren können natürlich auch für die Panelanalyse verwendet werden. So können Häufigkeiten und Mittelwerte zu verschiedenen Messzeitpunkten als erste Analysen berechnet werden. Durch Kreuztabellierung können darüber hinaus Veränderungs- bzw. Haltequoten gemessen werden.

9. Nutzen Sie auch bivariate Korrelationen

Auch Korrelationen zwischen zwei inhaltlich identischen Variablen, die zu verschiedenen Zeitpunkten erhoben werden, können für die Panelanalyse genutzt werden. Hierbei müssen Sie aber unbedingt die völlig andere Interpretation dieser Koeffizienten beachtet. So werden bei dieser Art von Korrelationen nicht Zusammenhänge berechnet, sondern es handelt sich bei diesen Koeffizienten um Stabilitätsmaße. Diese Maße können sowohl zeitliche Stabilität als auch gleichmäßige, proportionale Veränderungen darstellen.

10. Gerichtete Effekte können durch Regressionen ermittelt werden

Neben Korrelationen können Sie auch gerichtete Effekte zwischen einer Variablen, die zum ersten Zeitpunkt und der gleichen Variablen, gemessen zu einem zweiten Zeitpunkt, berechnen. Aber auch hier müssen die standardisierten Regressionskoeffizienten – analog zu den Korrelationen – als Stabilitätsmaße interpretiert werden.

erschienen auf planung&analyse:

https://www.horizont.net/planung-analyse/nachrichten/10-Praxis-Tipps-Panelanalyse-in-der-Meinungsforschung-152548

—————————————————————————-

Mediaforschung: Kundenmagazine

1. Nutzen Sie als kostengünstige Methode schriftliche Leserumfragen mit Fragebogen als Beileger im Heft.

Eine häufig angewandte Methode, um Leseverhalten und Heftbewertung bei Kundenmagazinen zu ermitteln, ist die schriftliche Leserumfrage mit einem im Heft eingelegten Fragebogen. Vorteil dieser Methode sind die relativ geringen Kosten. Umfrageteilnehmer sind aber vor allem regelmäßige und zufriedene Leser des Magazins.

2. Nutzen Sie schriftliche redaktionelle Copytests, wenn Sie eine umfassende Ergebnisse zur redaktionellen Bewertung und zum Leseverhalten benötigen.

Um umfassende redaktionelle Bewertungen einzelner Artikel und detaillierte Angaben zum Nutzungsverhalten zu ermitteln, sind sog. redaktionelle Copytests die geeignete Methode. Auf der Grundlage einer repräsentativen Stichprobe und dem Vorabversand einer Ausgabe des Kundenmagazins an die Teilnehmer können dann persönliche oder telefonische Interviews oder eine postalische Befragung über Heftinhalte, Artikelbewertungen und Leseverhalten durchgeführt werden.

3. Bieten Sie den Teilnehmer eine kleine Belohnung an.

Um die Teilnahmebereitschaft an Mediastudien zu erhöhen, sollten Sie den Befragten eine kleine Belohnung anbieten: Sinnvoll ist entweder ein Gewinnspiel mit attraktiven Preisen oder ein kleines Dankeschön für jeden Teilnehmer.

4. Orientieren Sie sich bei der Konzeption repräsentativer Mediastudien für Kundenmagazine an den bestehenden Standards für Reichweiten- und Leserstrukturanalysen.

Vom Zentralausschuss der deutschen Wirtschaft e. V. (ZAW) sind Richtlinien für Mediaforschung, Anzeigenverkauf und Vermarktung entwickelt worden, die sich als allgemein gültige „Währung“ etabliert haben. Dieses ZAW-Rahmenschema für Werbeträgeranalysen sollten Sie bei der Entwicklung von Reichweiten- und Leserstrukturanalyse unbedingt beachten.

5. Wenn Sie Leserstrukturanalysen durchführen möchten, setzen Sie telefonische Umfragen ein.

Für die Durchführung von repräsentativen Leserstrukturanalysen bieten sich insbesondere telefonische Interviews an. In den Kundendaten sind häufig die Telefonnummern enthalten oder lassen sich relativ einfach ermitteln. So können allgemeine Angaben zur Heftbewertung und zum Leseverhalten sowie zur Leserstruktur ermittelt werden.

6. Befragen Sie neben Lesern auch Nicht-Leser, wenn Sie die Kommunikationsleistungen von Kundenmagazinen ermitteln möchten.

Eine zentraler Leistungsfaktor von Kundenmagazinen stellt die Kommunikationswirkung dar. Hier stehen unter anderem das Image des jeweiligen Unternehmens und die Kaufbereitschaft von Produkten des Unternehmens im Mittelpunkt. Am besten lässt sich die Kommunikationswirkung von Kundemagazinen dann nachweisen, wenn man Leser und Nicht-Leser in die Umfrage einbezieht.

7. Nutzen Sie bereits bewährte Abfragemodelle zur Heftnutzung und Heftbewertung.

Nutzen Sie bewährte Frageformulierungen und Skalen bei quantitativen Mediastudien. Gerade in der Mediaforschung haben sich Standards in der Frageformulierung durchgesetzt, um die Vergleichbarkeit von Leistungswerten sicher zu stellen.

8. Wenn Sie vertiefte Informationen über Leserbewertung und Nutzungsverhalten benötigen, nutzen Sie Gruppendiskussionen.

Wenn Sie vertiefte Bewertungsmuster über ein Kundenmagazin erhalten möchten, bietet sich die Methode der Gruppendiskussion an. Hier werden in kleinen Gruppen unter Anleitung eines Moderators Heftbeurteilung, Nutzung, Likes und Dislikes sowie Themeninteressen diskutiert und ermittelt.

9. Nutzen Sie die Möglichkeiten von Treiberanalysen aus der Kundenzufriedenheitsforschung auch für die Mediaanalyse.

Um Ansatzpunkte für die redaktionelle Optimierung von Kundenmagazinen zu erhalten, eignen sich auch Methoden aus anderen Bereiche der Marktforschung wie z.B. aus der Kundenzufriedenheitsforschung. So können Treiberanalysen die wichtigen Faktoren für die Heftbewertung aufzeigen.

10. Zur Analyse der Positionierung mehrerer Kundenmagazine können Sie die Methode der Korrespondenzanalyse nutzen.

In manchen Unternehmen werden verschiedene Kundenmagazine für unterschiedliche Zielgruppen bzw. Themen herausgegeben. Hier kann durch quantitative Mediaanalysen einzelne Titelprofile in der jeweiligen Leserschaft abgefragt werden. Die einzelnen Prozentwerte der in den unterschiedlichen Mediastudien / Zielgruppen ermittelten Titelprofile können dann im Rahmen einer Korrespondenzanalyse (mit Hilfe von SPSS o.a.) analysiert werden und so die Positionierung der einzelnen Magazine in jeweiligen Leserschaft überprüft werden.

erschienen auf planung&analyse:

https://www.horizont.net/planung-analyse/nachrichten/10-Praxis-Tipps-Mediaforschung-Kundenmagazine-152555

zurück zur Hauptseite:

https://mediaresearchinstitute.wordpress.com/

—————————————————————————-

Geodata Analysis

Satellite Photography of Montenegro

- Satellite photography with Sentinel2

- Agriculture layer with contours

- Processed with sentinel-hub and QGIS

Satellite Photography of Egypt, Abu Simbel

- Satellite photography with Sentinel2

- False Color Spectrum (Vegetation)

- Processed with sentinel-hub and QGIS

- Red colour: agricultural area, black colour: Nile

Satellite Photography of Genoa, Italy (2019)Satellite photography with Sentinel2

False NDVI – Normalized Difference Vegetation Index

This most known and used vegetation index is a simple, but effective VI for quantifying green vegetation. It normalizes green leaf scattering in the Near Infra-red wavelength and chlorophyll absorption in the red wavelength.Values description: The value range of an NDVI is -1 to 1. Negative values of NDVI (values approaching -1) correspond to water. Values close to zero (-0.1 to 0.1) generally correspond to barren areas of rock, sand, or snow. Low, positive values represent shrub and grassland (approximately 0.2 to 0.4), while high values indicate temperate and tropical rainforests (values approaching 1).

Moisture Soil Index

The NDMI is a normalized difference moisture index, that uses NIR and SWIR bands to display moisture. The SWIR band reflects changes in both the vegetation water content and the spongy mesophyll structure in vegetation canopies, while the NIR reflectance is affected by leaf internal structure and leaf dry matter content but not by water content. The combination of the NIR with the SWIR removes variations induced by leaf internal structure and leaf dry matter content, improving the accuracy in retrieving the vegetation water content. The amount of water available in the internal leaf structure largely controls the spectral reflectance in the SWIR interval of the electromagnetic spectrum. SWIR reflectance is therefore negatively related to leaf water content.

Satellite Photography of Rijeka, Croatia

Moisture Soil Index and Contours

Remote Sensing and Social Research

Remote sensing in urban studies has a long history. Early studies used photo interpreted data as auxiliary data sources in a census, or to predict socioeconomic variables such as poverty from housing density, structure type or vegetation

cover.

Aerial photography remains in use today, but the need for frequent and comprehensive coverage of urban areas at low cost has led to an interest in satellite imagery. Other social science issues applicable to remote sensing exist, such as are urban growth and development, quality of life, and urban population density and structure.

Several studies exist that quantify land cover changes in order to address urban growth over periods of time. However, this

application is particularly demanding in terms of preprocessing of remote sensing data.

Several attempts exist where remote sensing imagery was used to produce population counts.The interpretation of land-use and land cover change data

dominates the research agendas of many private and public research institutions.

An understanding of land-change has emerged as a fundamental element of how global environment change is occurring and the sustainability sciences have called for an integration of the social and physical sciences. Human land use is a critical link between society and the modification of hydrology, ecology, geomorphology, climate and biogeochemical processes. Land use is the term that describes the human use of the land, e.g. grazing and agriculture.

Hall, Ola: Remote Sensing in Social Science Research, in: The Open Remote Sensing Journal, 2010, 3, 1-16